layout: post title: “(ENG) The basics of Spark PART 2” author: tuyennnt categories: [ Data ] image: assets/images/spark.png —

PySpark APIs tương tự như Pandas và Scikit-learn

schema1 = StructType([StructField('id', IntegerType(), True),

StructField('create_date', StringType(), True),

StructField('txn_date', StringType(), True)])

sc.version

2.3.1

sc.pythonVer

3.6

sc.master

local[*]

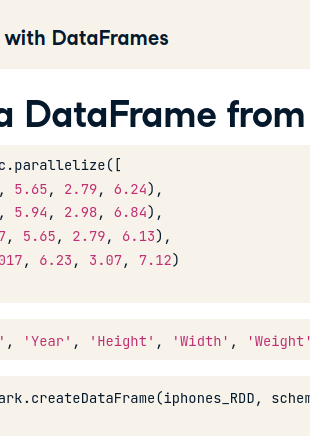

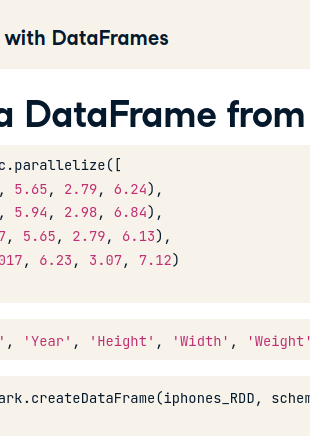

spark.createDataFrame()parallelize method của SparkContext với input là 1 list.

rdd = sc.parallelize([1,2,3,4,5])

Tạo parallelize collection lưu số từ 1 đến 5

textFile()

rdd2 = sc.textFile("test.txt")

spark.read.csv("...", header = True, inferSchema=True)

spark.read.json("...")

spark.read.txt("...")

names

df = spark.createDataFrame(RDD, schema=names)

https://saagie.zendesk.com/hc/en-us/articles/360029759552-PySpark-Read-and-Write-Files-from-HDFS